OpenAI发布GPT-OSS开源模型

|

2025年8月5日OpenAI发布GPT-OSS开源模型,使用许可协议:Apache 2.0,模型定位:高性能本地化推理。

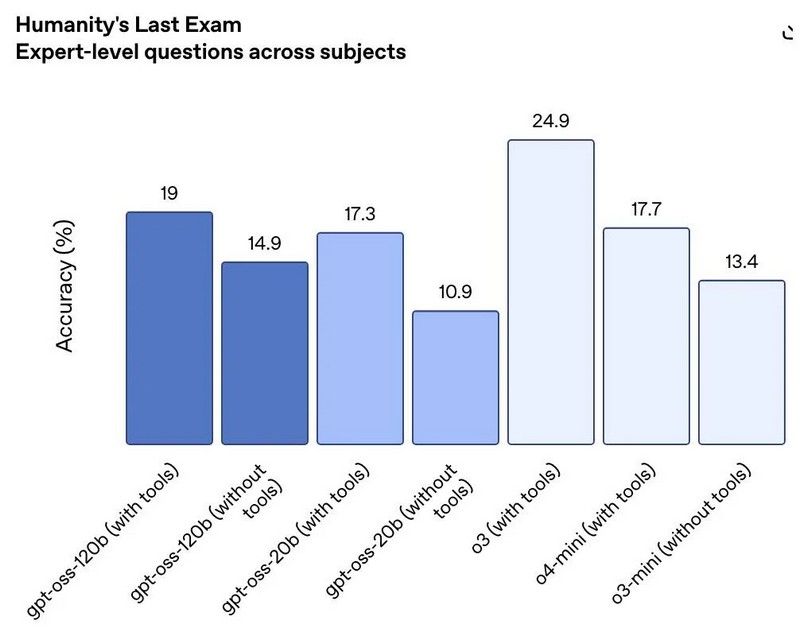

一、核心模型参数与性能对标 GPT-OSS-120B(1170亿参数)性能对标:推理能力接近OpenAI自有闭源模型o4-mini,在编程(Codeforces)、数学竞赛(AIME 2025)和医疗健康(HealthBench)等专业任务中表现优异28。 效率优化:采用混合专家(MoE)架构,每个token仅激活51亿参数,显著降低计算负载18。 GPT-OSS-20B(210亿参数) 性能对标:综合表现与o3-mini相当,可在16GB内存的消费级设备(如MacBook Pro或高端安卓手机)流畅运行210。 边缘计算优势:在M3 Pro芯片MacBook Pro上实测生成代码速度达23.72 token/秒,适合本地化AI助手开发23。 二、技术架构创新 MoE稀疏激活: 120B模型:128个专家中动态路由激活4个(共51亿参数)15。 20B模型:32个专家中激活36亿参数,平衡性能与能效910。 原生4-bit量化(MXFP4):专为MoE层设计,降低显存需求,支持消费级硬件部署810。 128K上下文窗口:结合旋转位置嵌入(RoPE),优化长文本处理,但落后于Qwen3(256K)等竞品18。 三、安全与训练机制 对抗性安全测试:通过“最坏情况微调”(Worst-Case Fine-Tuning)模拟恶意攻击,强制模型生成高危内容(如生化武器设计),结果显示其难以有效执行有害指令15。 强化学习对齐:采用与o4-mini相似的RLHF流程,注入链式推理(Chain-of-Thought)能力,用户可通过系统提示(如Reasoning: high)动态调节推理强度14。 红队挑战赛:设立50万美元奖金,鼓励社区发现新型安全漏洞18。 四、开源生态与部署支持 宽松商用许可:Apache 2.0协议允许企业自由修改、分发及商用,无需公开衍生代码28。 全平台部署适配: 本地工具:Ollama、LM Studio(支持Windows/macOS一键部署)39。 云服务:Azure/AWS预集成镜像,Hugging Face模型仓库610。 企业级场景:支持函数调用、网页检索、Python执行等Agentic能力,满足金融、医疗等行业私有化需求810。 五、局限性与行业影响 多模态缺失:仅支持文本输入/输出,无图像或音频处理能力17。 幻觉率偏高:在人物知识测试(PersonQA)中错误率达49%(120B)和53%(20B),显著高于闭源模型48。 生态冲击:倒逼DeepSeek、GLM-4.5等开源模型升级,加速行业竞争从“参数规模”转向“安全-效率-成本”三角平衡8。 模型规格对比速览

结语:OpenAI的战略转向 此次开源标志着OpenAI从“闭源API主导”转向“开源-闭源双轨并行”,回应了行业对技术透明度的诉求48。而Sam Altman预告的“本周重大更新”(或为GPT-5),进一步预示开源与闭源模型的协同进化将重塑AI生态48。 |

商情

商情